OpenAI propose deux modèles de langage open source : GPT-OSS-20B et GPT-OSS-120B. Vous pouvez les utiliser gratuitement, même pour un usage commercial, grâce à la licence Apache 2.0. Ces modèles excellent en raisonnement, en génération de code, en mathématiques et dans bien d’autres tâches. Leur qualité rivalise avec certaines versions de GPT-4. Vous pouvez les faire tourner localement sur votre ordinateur, sans connexion Internet. Dans cet article, vous allez découvrir deux façons simples d’utiliser GPT-OSS : avec Ollama en ligne de commande ou avec LM Studio, une interface graphique proche de ChatGPT.

Prérequis matériels et logiciels (Mac et PC)

Avant de vous lancer, assurez-vous de disposer de la configuration adéquate, que ce soit sur Mac ou sur PC Windows. GPT-OSS étant un modèle volumineux, il est essentiel de vérifier les prérequis suivants :

Pour les utilisateurs Mac (macOS):

- Matériel : Un Mac équipé d’un processeur Apple Silicon (M1, M2 ou supérieur) est fortement recommandé. OpenAI conseille au moins 16 Go de mémoire unifiée pour exécuter le modèle 20B dans de bonnes conditions. En dessous, le modèle peut ne pas tenir en mémoire ou tourner très lentement.

En pratique, 16 Go représente un minimum, et 32 Go (ou plus) apportent un meilleur confort. Plusieurs utilisateurs ont constaté que des requêtes pouvaient prendre plusieurs minutes avec seulement 16 Go de RAM, faute de ressources suffisantes.

Prévoyez également 15 Go d’espace disque libre pour télécharger le modèle 20B. Le modèle 120B dépasse quant à lui les 60 Go. - Logiciel : Une version récente de macOS est recommandée. Vous pouvez utiliser Ollama, LM Studio, ou les deux. Ces outils sont compatibles macOS. Il vous faudra aussi accéder au Terminal pour certaines commandes de base.

Pour les utilisateurs PC (Windows):

- Matériel : L’idéal est de disposer d’un GPU avec au moins 16 Go de VRAM, comme une NVIDIA RTX 30/40. Si vous n’avez pas de GPU puissant, GPT-OSS peut tourner sur CPU, mais les temps de réponse seront bien plus longs.

La version 120B du modèle est très exigeante et nécessite environ 60 Go de VRAM, souvent sur une configuration multi-GPU.

Pour un usage standard, préférez donc GPT-OSS-20B avec un GPU moderne. Pensez aussi à libérer 15 Go de stockage pour le modèle. - Logiciel : Windows 10 ou supérieur est nécessaire. Ollama propose une version preview pour Windows. LM Studio est également compatible. Vous devez pouvoir exécuter des fichiers .exe (droits administrateur) et utiliser PowerShell ou cmd pour les étapes d’installation.

Pour les utilisateurs Linux:

Ollama et LM Studio proposent tous deux des versions compatibles Linux. Les étapes d’installation sont proches de celles de Windows. Les besoins matériels sont également les mêmes : 16 Go de RAM minimum, un GPU dédié si possible, et suffisamment d’espace disque.

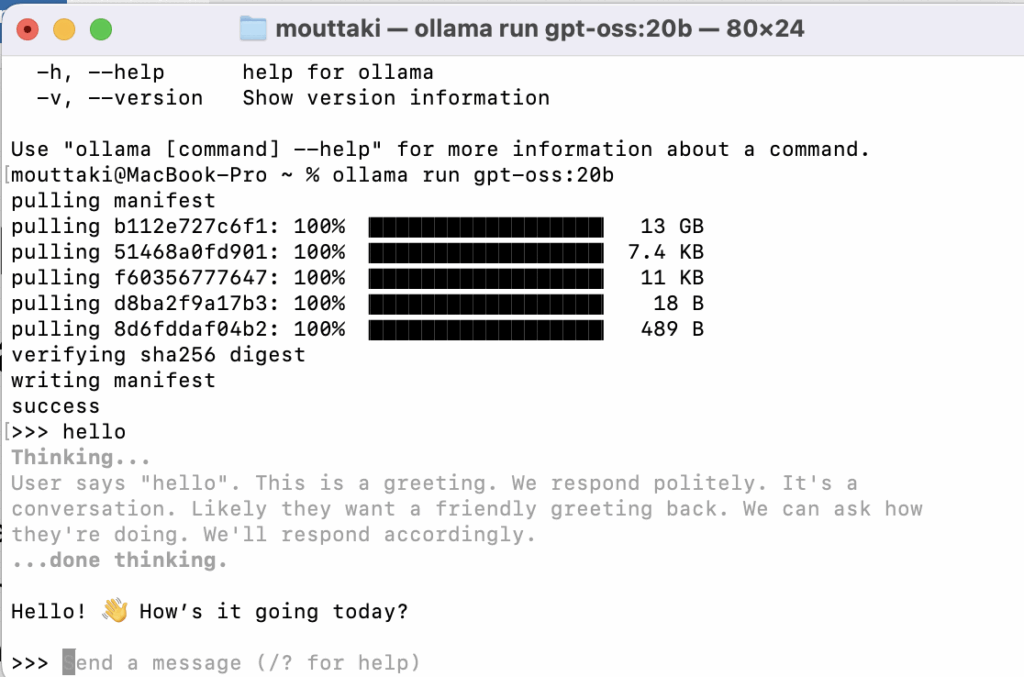

Utiliser GPT-OSS en local avec Ollama

Ollama est un outil open source qui permet de faire fonctionner des modèles LLM directement sur une machine locale. Initialement conçu pour macOS, Ollama est aujourd’hui disponible aussi sur Linux et Windows (via WSL) et s’installe facilement (par exemple via Homebrew sur Mac). Une fois installé, Ollama offre une bibliothèque de modèles prêts à l’emploi et optimisés, et lance un service local sur votre machine pour les exécuter.

Étapes pour utiliser GPT-OSS avec Ollama :

- Installer Ollama : Téléchargez l’installateur adapté à votre système depuis le site officiel d’Ollama (disponible pour macOS 12+, Windows 10+ et Linux) ou via un gestionnaire de paquets.

- Télécharger le modèle GPT-OSS : Exécutez la commande ollama pull gpt-oss:20b pour récupérer le modèle openai/gpt-oss-20b localement. (Le modèle 20B pèse environ 14 Go et fonctionne avec ~16 Go de RAM, tandis que le 120B exige plus de 60 Go de RAM ; assurez-vous donc que votre matériel est adapté.)

- Lancer le modèle en local : Utilisez la commande ollama run gpt-oss:20b pour démarrer le modèle en mode chat. Vous pouvez alors entrer vos requêtes directement dans le terminal et obtenir des réponses générées par GPT-OSS, le tout hors-ligne sur votre machine.

Ollama va ainsi télécharger puis faire tourner le modèle GPT-OSS en local. En arrière-plan, il optimise l’exécution grâce à des techniques comme la quantification en 4 bits (format MXFP4) pour réduire l’empreinte mémoire. Cet outil reste cependant purement en ligne de commande. Pour ceux qui préfèrent une interface utilisateur de chat plus familière à celle d’OpenAI, nous vous conseillons d’utiliser LM Studio.

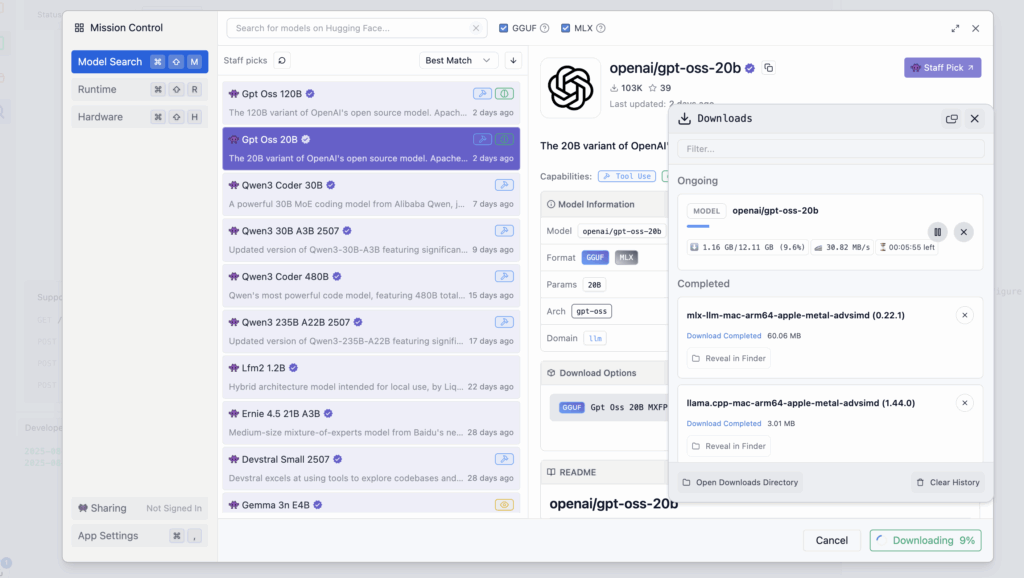

LM Studio : une interface simple pour utiliser les modèles en local

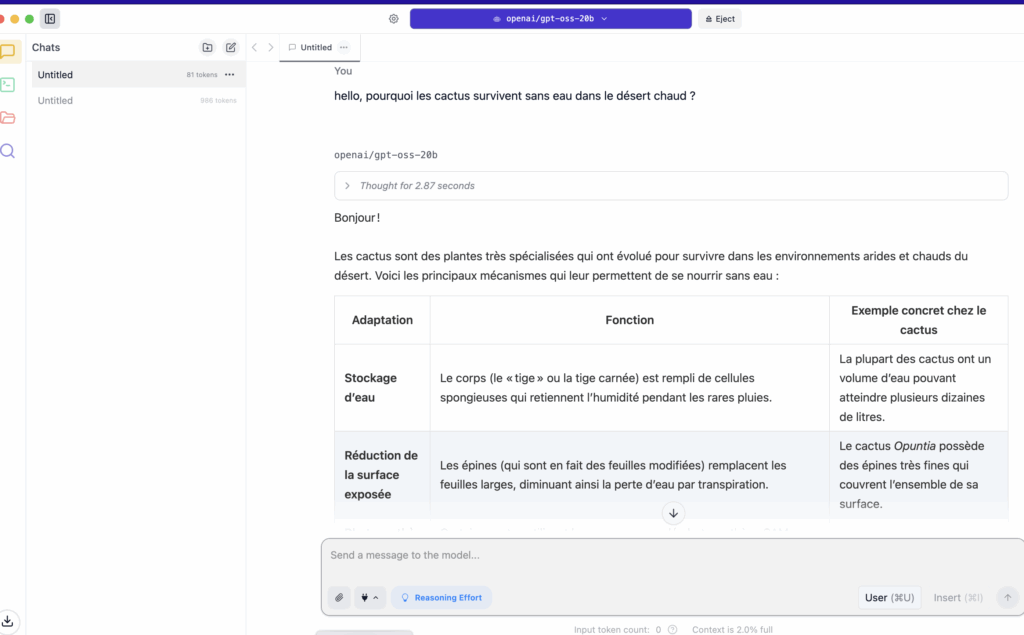

LM Studio est une application de bureau disponible sur Mac, Windows et Linux. Elle permet d’utiliser facilement des modèles d’IA localement, sans ligne de commande. Son interface ressemble à celle de ChatGPT. Vous pouvez discuter avec un LLM en local, comme vous le feriez en ligne.

L’application intègre aussi un gestionnaire de modèles. Vous pouvez rechercher et télécharger des modèles directement depuis Hugging Face. Pas besoin d’écrire une seule ligne de code. LM Studio accepte les modèles compatibles au format GGUF.

Installer LM Studio

Rendez-vous sur lmstudio.ai et téléchargez l’installateur adapté à votre système.

L’application fonctionne sur macOS (y compris Apple Silicon), Windows (x64 ou ARM64), et Linux.

Lancez LM Studio comme une application classique après l’installation.

Utiliser GPT-OSS avec LM Studio

- Ouvrez LM Studio.

- Appuyez sur

Ctrl + Shift + Mpour accéder au gestionnaire de modèles. - Recherchez gpt-oss.

- Cliquez pour télécharger le modèle depuis Hugging Face.

Le modèle s’installe automatiquement. Une fois prêt, sélectionnez-le dans la liste, puis lancez une nouvelle session de chat.

Vous pouvez poser vos questions directement. Les réponses s’affichent comme dans ChatGPT. Tout fonctionne en local, sans connexion Internet.

Pourquoi choisir LM Studio ?

LM Studio offre une expérience fluide. Vous utilisez l’IA localement, sans configuration complexe.

Vous pouvez aussi gérer vos modèles (mise à jour, suppression).

Certaines fonctions avancées sont disponibles :

- Chat avec des documents en local (RAG)

- Paramètres de génération personnalisables

- Option d’API locale compatible OpenAI (pour les développeurs)

Mais surtout, LM Studio reste simple et pratique. Il vous donne accès à la puissance de GPT-OSS sans vous compliquer la vie.

En résumé, les nouveaux modèles GPT-OSS d’OpenAI peuvent être exploités localement de deux manières complémentaires. Ollama permet une gestion simple via la ligne de commande, idéale pour les développeurs ou une intégration système, tandis que LM Studio fournit une interface graphique conviviale inspirée de ChatGPT pour interagir facilement avec les modèles open source.

Grâce à ces outils, n’importe qui peut désormais tester et utiliser chez soi des modèles de langage puissants et open source, sans dépendre d’un service cloud. Cette démocratisation des LLM open source, combinée à des licences permissives, ouvre la voie à de nouvelles expérimentations et applications locales de l’IA – le tout à la portée des utilisateurs sur leurs propres machines.